Über das ProjektMagazin

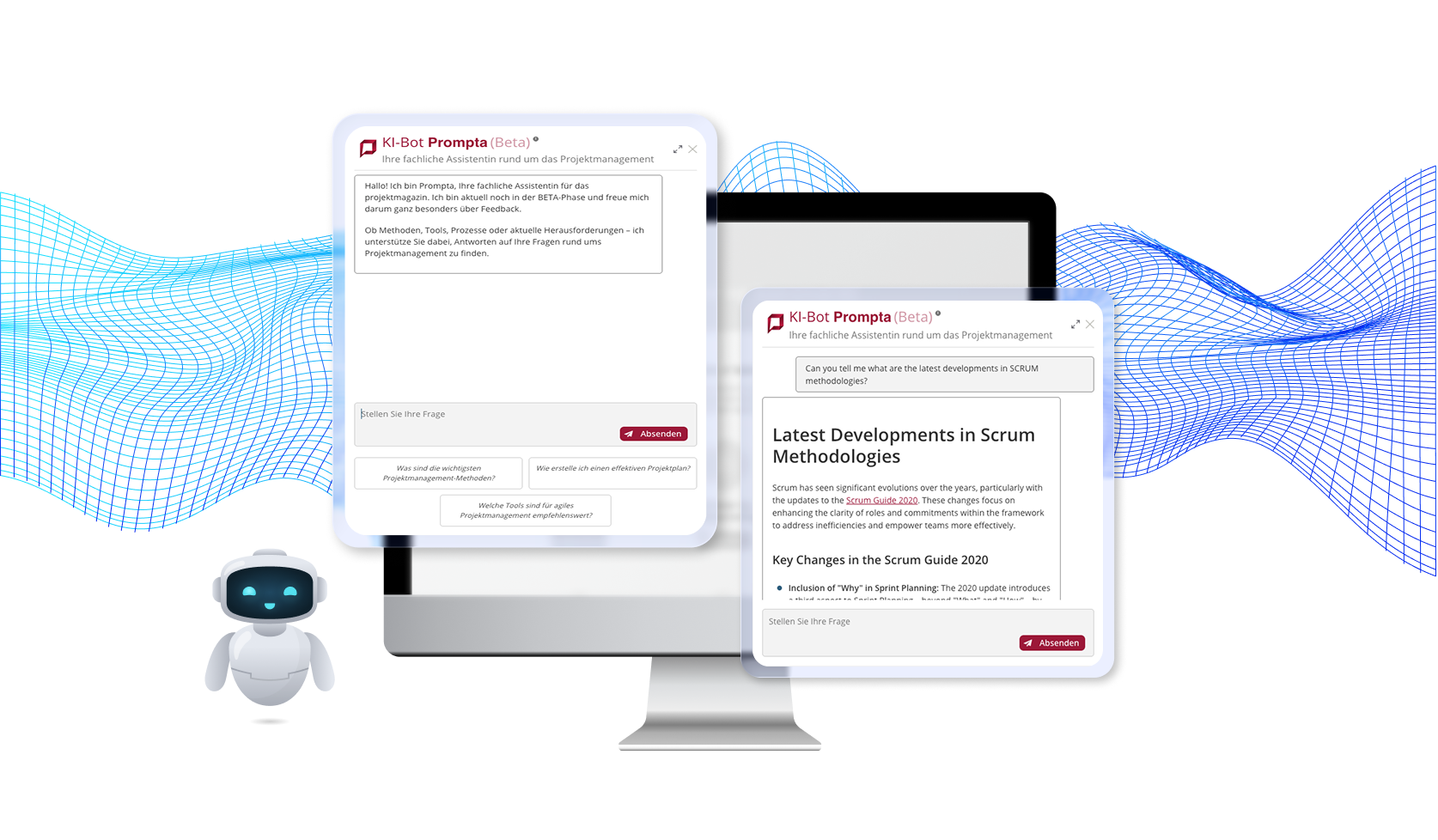

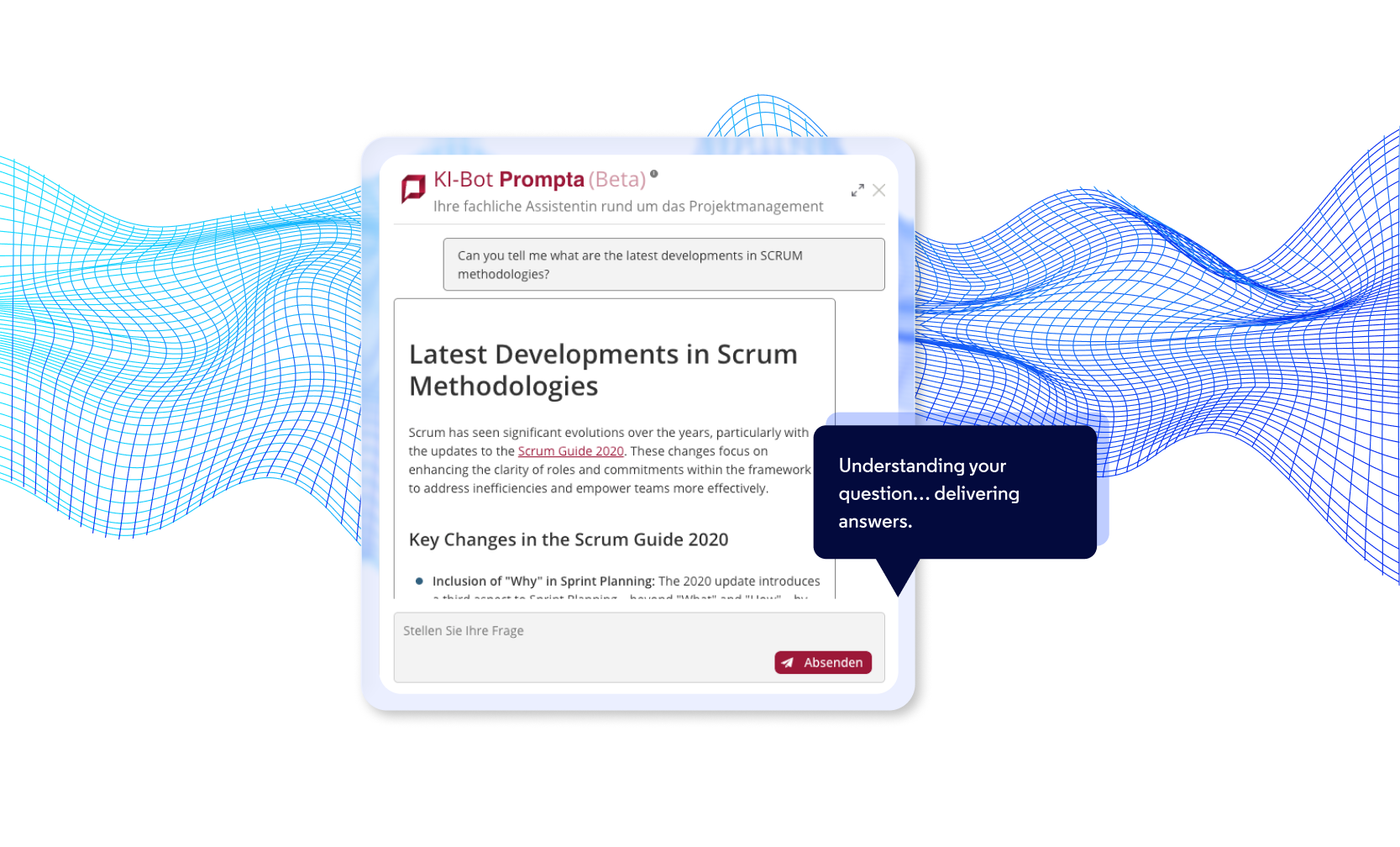

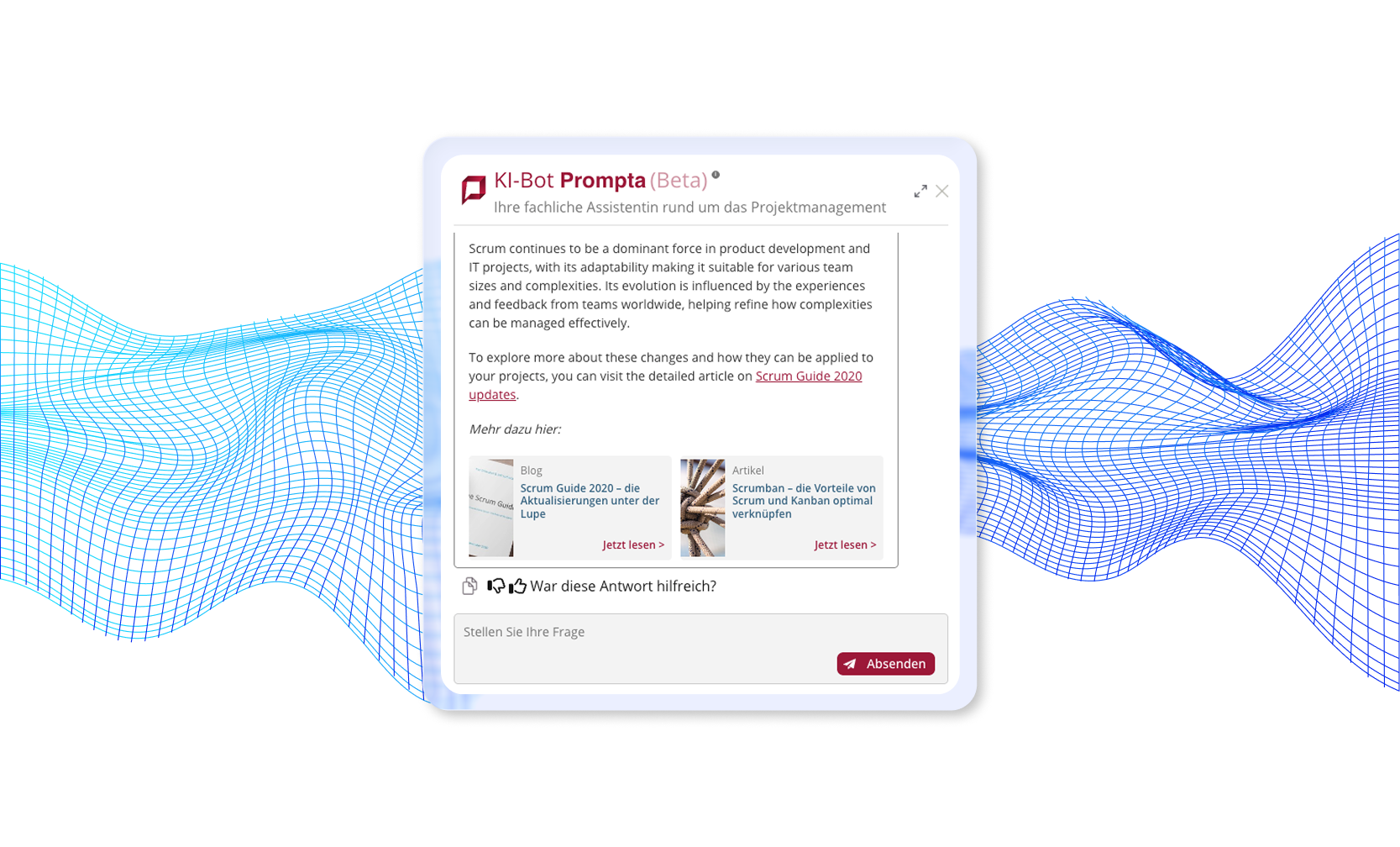

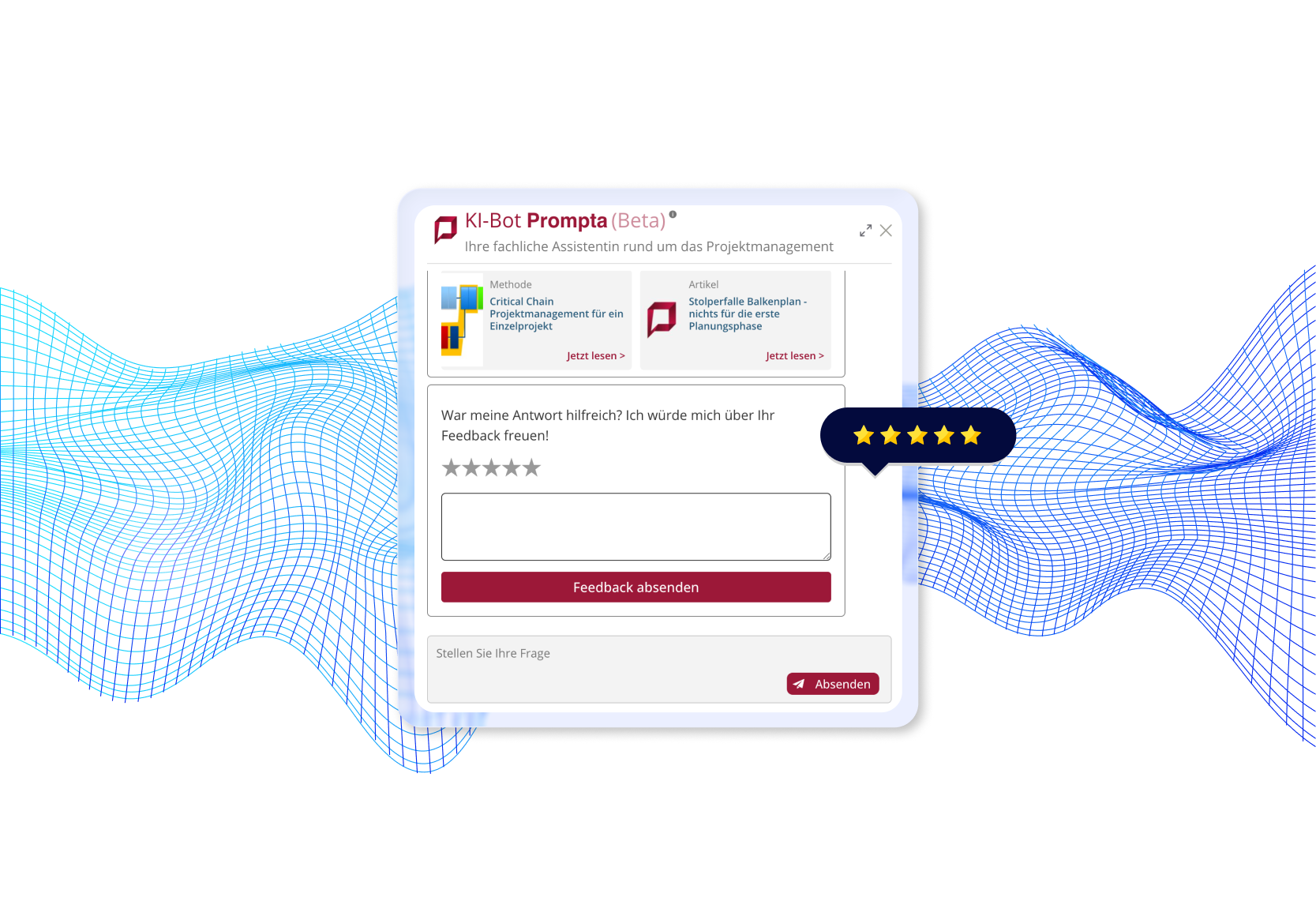

Was wir gebaut haben

Auswirkungen auf das Geschäft und betriebliche Verbesserungen

Der Kunde berichtet von einer hohen Benutzerzufriedenheit und hat bereits visuelle Verbesserungen der Benutzeroberfläche als nächste Verbesserungsphase identifiziert – ein klares Zeichen dafür, dass die Kernfunktionalität alle seine Anforderungen erfüllt.

Technologieauswahl

Wir haben unseren Technologie-Stack auf der Grundlage von Produktionssicherheit, Skalierbarkeit und langfristiger Wartbarkeit ausgewählt.

Lesen Sie mehr über die technischen Aspekte dieses Projekts in unserem Blog

In unseren Artikeln erläutern wir unter anderem, wie wir die Aktualität des Chatbot-Wissens sichergestellt haben, wie wir Werkzeuge und Frameworks für den Aufbau einer stabilen RAG-Pipeline ausgewählt haben und welche Techniken wir eingesetzt haben, um die Antwortzeiten zu verkürzen und die Genauigkeit der generierten Ergebnisse zu erhöhen.