Echtzeit-Datensynchronisation für RAG. Wie Sie das Wissen Ihres KI-Chatbots aktuell halten

Ihr Marketing-Team hat gerade eine wichtige Richtlinienaktualisierung veröffentlicht. Zwei Stunden später fragt ein Benutzer Ihren AI-Chatbot nach der neuen Richtlinie, und dieser erklärt zuversichtlich die alte Version - vollkommen unbewusst, dass sich etwas geändert hat. Der Benutzer, verwirrt durch die Diskrepanz zu dem, was er auf der Website gelesen hat, öffnet ein Support-Ticket und fragt, warum der Chatbot "kaputt" ist. Ihr Team erklärt, dass der Chatbot manuell neu indiziert werden muss, was nächtlich geschieht. Das Vertrauen des Benutzers in Ihr AI-System sinkt erheblich.

Dies ist die verborgene Zerbrechlichkeit von statischen RAG-Implementierungen: Die Wissensbasis ist veraltet, sobald sich der Inhalt ändert. In schnelllebigen Organisationen, in denen Dokumentationen, Richtlinien und Produktinformationen täglich oder sogar stündlich aktualisiert werden, ist ein Chatbot mit dem Wissen von gestern schlimmer als gar kein Chatbot. Benutzer erwarten aktuelle Informationen und wenn die KI versagt, hören sie auf, sie zu nutzen.

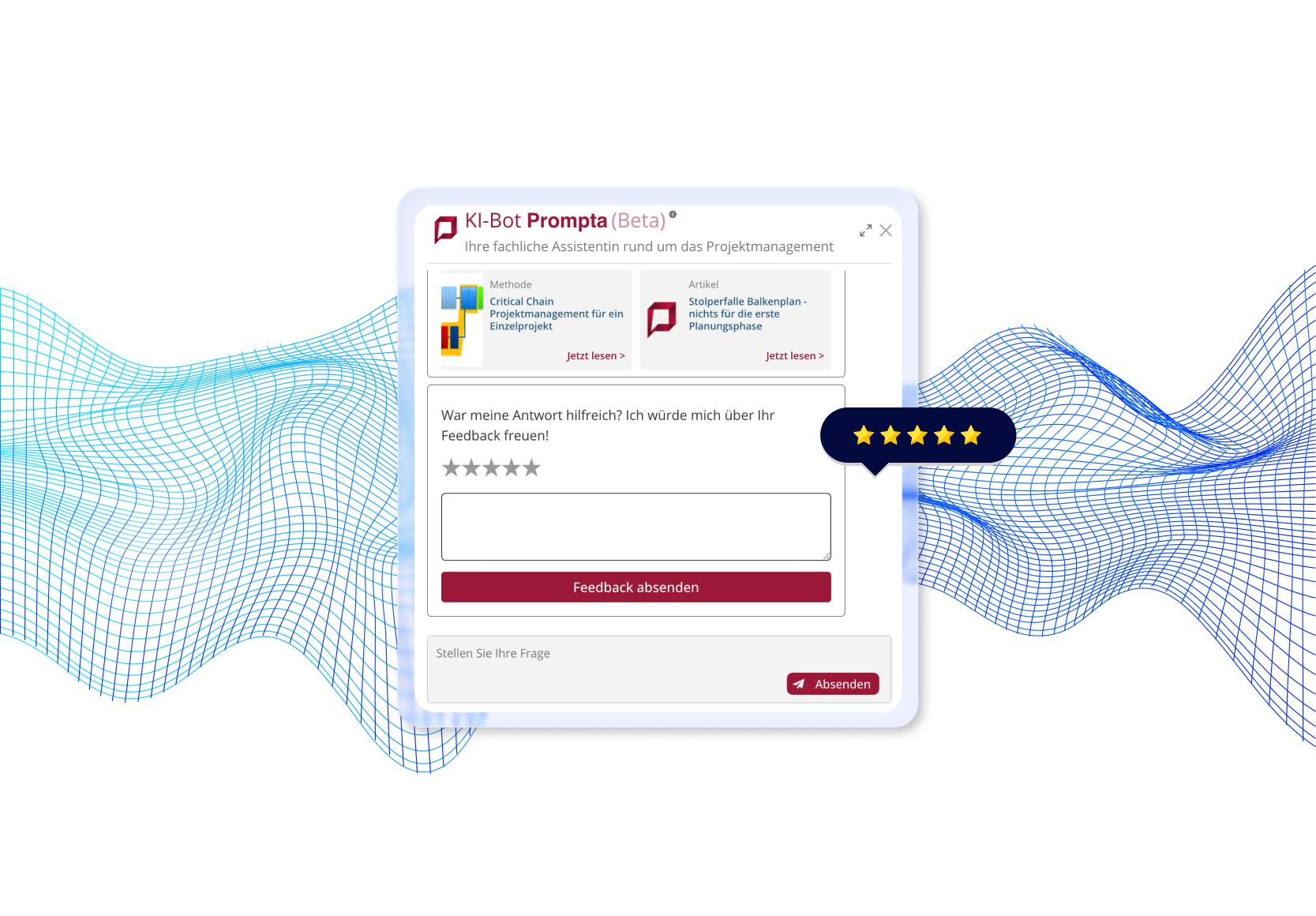

Wir standen genau vor dieser Herausforderung, als wir einen KI-Dokumenten-Chatbot für eine professionelle Wissensmanagement-Plattform entwickelten, die wöchentlich Dutzende von Artikeln und Updates veröffentlicht. Durch die Implementierung eines Echtzeit-Synchronisationssystems mit Webhooks und nächtlichen Konsistenzprüfungen konnten wir Aktualisierungen erreichen, die Benutzern innerhalb von 30 Sekunden sichtbar sind, während wir die Systemzuverlässigkeit über 11 verschiedene Inhaltsarten aufrechterhielten.

In diesem Artikel werde ich Ihnen das Problem des veralteten Wissens erläutern, unsere duale Synchronisierungsarchitektur erklären, Implementierungsdetails mit Produktionscode-Beispielen teilen und Ihnen helfen zu entscheiden, wann Echtzeit-RAG für Ihre Anwendung sinnvoll ist.

In diesem Artikel:

- Was ist das Problem des veralteten Wissens in statischen RAGs?

- Echtzeit-Datensynchronisation zur Rettung

- Wie funktioniert eine Echtzeit-Synchronisationsarchitektur?

- Wie wird die Echtzeit-Datensynchronisation in der Praxis umgesetzt?

- Welche Ergebnisse kann eine Echtzeit-Synchronisation in der Produktion liefern?

- Wann macht eine Echtzeit-Synchronisation Sinn (und wann nicht)?

- Echtzeit-Datensynchronisation für RAG - Schlussfolgerung

- Möchten Sie Echtzeit-RAG-Systeme erstellen?

Was ist das Problem des veralteten Wissens in statischen RAGs?

Die meisten RAG-Systeme behandeln die Indizierung als einmalige oder geplante Batch-Operation. Sie scrapen oder laden Ihre Dokumente, zerteilen sie, erzeugen Einbettungen, speichern sie in einer Vektor-Datenbank und betrachten die Arbeit als erledigt. Das funktioniert perfekt - bis sich Ihr Inhalt ändert.

Traditionelle Indexierungsansätze

Traditionelle Indexierungsansätze verlassen sich auf periodische oder manuelle Updates, die unvermeidlich Verzögerungen zwischen den Inhaltsänderungen und dem, was der Chatbot abrufen kann, einführen.

Batch-Indexierung

Organisationen indizieren typischerweise ihre gesamte Wissensbasis nach einem festgelegten Zeitplan: wöchentlich, täglich oder (optimistisch) stündlich. Ein Skript wird ausgeführt, verarbeitet alle Dokumente, regeneriert die Einbettungen und aktualisiert die Vektordatenbank. Einfach, vorhersehbar und zunehmend unzureichend.

Manuelle Auslöser

Einige Teams implementieren "Jetzt neu indizieren"-Tasten, die Content-Manager anklicken, nachdem sie Änderungen veröffentlicht haben. Dies erfordert Disziplin, fügt Reibung zu den Content-Workflows hinzu und wird unweigerlich in geschäftigen Zeiten oder bei dringenden Updates vergessen.

Vollständige geplante Neuindizierung

Der gängigste Ansatz: nächtliche Cron-Jobs, die die gesamte Wissensbasis erneut verarbeiten. Dies stellt die letztendliche Konsistenz sicher, schafft jedoch ein Zeitfenster von Stunden oder Tagen, in dem der Chatbot mit veralteten Informationen arbeitet.

Echtzeit-Datensynchronisation zur Rettung

Echtzeit-Datensynchronisation beseitigt diese Veraltenheitsfenster, indem sie die Wissensbasis automatisch innerhalb von Sekunden nach Inhaltsänderungen aktualisiert. Statt auf geplante Jobs zu warten oder manuelle Auslöser zu benötigen, erhält das System webhook-Benachrichtigungen, sobald Redakteure Änderungen im CMS speichern. Dieser ereignisgesteuerte Ansatz bedeutet, dass die Benutzer immer aktuelle Informationen abfragen, ohne dass eine Koordination zwischen Content-Teams und technischen Betrieb erforderlich ist.

Wie funktioniert eine Echtzeit-Datensynchronisationsarchitektur?

Unsere Produktionslösung implementiert einen dualen Ansatz, der sofortige Reagibilität mit langfristiger Konsistenz vereint. Die Architektur besteht aus vier Schlüsselkomponenten, die zusammenarbeiten, um sicherzustellen, dass das Wissen des Chatbots aktuell bleibt.

Komponente 1: Webhook-basierte Neuindizierung

Das Fundament der Echtzeit-Datensynchronisation sind ereignisgesteuerte Updates. Wenn sich der Inhalt in der CMS-Lösung ändert, erfährt der Chatbot sofort davon durch Webhooks.

So funktioniert es:

- Inhaltsredakteur speichert Dokument: Ein Redakteur aktualisiert einen Artikel, fügt einen neuen Glossarbegriff hinzu oder ändert eine Seite in der Wissensbasis in Drupal und klickt auf "Speichern".

- Drupal löst Webhook aus: Sofort nach dem Speichern sendet Drupal eine POST-Anforderung an unsere Python-API mit dem Entity-Typ und der ID:

POST https://ai-api.example.com/embeddings/articles/create

Body: {"nid": "12345"} - Python-API erhält Benachrichtigung: Unsere Flask-Anwendung erhält den Webhook und identifiziert, welcher Inhalt geändert wurde.

- Löschen Sie alte Chunks: Wir suchen alle vorhandenen Chunks für dieses Dokument in Elasticsearch und löschen sie. Dies verhindert Duplikate und gewährleistet saubere Updates.

- Frischen Inhalt abrufen: Das System ruft über die JSON-API von Drupal die neueste Version des Inhalts mit allen Metadaten, Absätzen und strukturierten Abschnitten ab.

- Neu aufteilen des Inhalts: Wir wenden unsere semantische Chunking-Strategie (200-700 Token pro Chunk) an, um das aktualisierte Dokument in optimale Teile für die Wiederherstellung zu unterteilen.

- Neuindizierung in Elasticsearch: Neue Chunks mit frischen Einbettungen werden in unserer Vektor-Datenbank gespeichert und ersetzen die alten Versionen.

- Aktualisierung sichtbar in <30 Sekunden: Das Refresh-Intervall von Elasticsearch (30 Sekunden) bestimmt, wann neue Inhalte durchsuchbar werden. Von Speichern bis Verfügbarkeit: unter 30 Sekunden.

Komponente 2: Entity-spezifische Endpunkte

Statt eines einzigen generischen Neuindizierungs-Endpunkts implementieren wir dedizierte Endpunkte für jeden Inhaltstyp. Dieser modulare Ansatz bietet Flexibilität und Isolation.

Unsere Endpunkte:

- /embeddings/articles/create

- Blog-Artikel und Langform-Inhalte

- /embeddings/authors/create

- Autorprofile und Biografien

- /embeddings/books/create

- Buchreferenzen und Rezensionen

- und mehr.

Vorteile von entity-spezifischen Endpunkten:

- Isolierte Fehler: Wenn die Indexierung der Autoren bricht, funktionieren die Artikel weiterhin.

- Typ-spezifische Verarbeitung: Jeder Inhaltstyp hat einzigartige Chunking-Anforderungen.

- Einfache Expansion: Das Hinzufügen neuer Inhalte beeinflusst nicht die bestehenden.

- Klare Protokollierung: Fehler zeigen genau an, welcher Typ und welche Entität fehlgeschlagen sind.

- Optimierte Verarbeitung: Unterschiedliche Inhalte können unterschiedliche Strategien verwenden.

Ein Beispiel für ein Projekt, in dem wir Echtzeit-RAG mit Webhook-Synchronisation implementiert haben

Lesen Sie die vollständige Fallstudie: AI Document Chatbot →

Komponente 3: Nächtlicher Synchronisationsjob

Webhooks bieten Echtzeit-Updates, sind aber nicht unfehlbar. Netzwerkfehler, API-Zeitüberschreitungen oder Probleme bei der Zustellung von Webhooks können dazu führen, dass Updates verpasst werden. Unser nächtlicher Synchronisationsjob fungiert als Sicherheitsnetz.

Was es jede Nacht um 2 Uhr macht:

- Abholen aller Inhalts-IDs von Drupal: Abfrage von Drupal nach vollständigen Listen aller Artikel, Autoren, Begriffe usw.

- Vergleichen mit indizierten Inhalten: Überprüfen von Elasticsearch auf den aktuellen indizierten Stand, einschließlich Metadaten-Zeitstempel.

- Abweichungen erkennen: Identifizieren von Inhalten, die in Drupal, aber nicht in dem Index existieren, oder von Inhalten mit Zeitstempeln, die anzeigen, dass sie sich seit der Indizierung geändert haben.

- Selektive Neuindizierung: Neuindizieren nur des Inhalts, der fehlt oder veraltet ist - nicht der gesamten Wissensbasis.

- Konsistenzbericht: Protokollieren von Statistiken: Wie viele Elemente waren nicht synchron, wie viele wurden neu indiziert, Erfolgs-/Fehlerraten.

CLI-Befehle für manuelle Operationen:

# Alle Artikel neu indizieren

flask index_articles

# Alle Autoren neu indizieren

flask index_authors

# Spezifische Entität neu indizieren

flask reindex_article --nid 12345

# Vollständige Konsistenzprüfung über alle Typen hinweg

flask verify_sync_allDiese Befehlszeilenschnittstelle ermöglicht es dem Betriebsteam, bei Bedarf manuell eine Neuindizierung auszulösen, was nützlich ist für die Fehlerbehebung oder Notfallupdates.

Komponente 4: Konsistenzmechanismen

Mehrere technische Muster gewährleisten die Datenintegrität während des Synchronisationsprozesses.

Muster "Delete-before-insert"

Bei der Neuindizierung eines Dokuments löschen wir immer vorhandene Chunks, bevor wir neue erstellen. Dies verhindert Duplikate, wenn der gleiche Inhalt mehrmals indiziert wird, und stellt einen sauberen Zustandsübergang sicher.

def reindex_document(doc_id, doc_type):

# Schritt 1: Löschen Sie alle vorhandenen Chunks

delete_query = {

"query": {

"bool": {

"must": [

{"term": {"metadata.node_id": doc_id}},

{"term": {"metadata.type": doc_type}}

]

}

}

}

elasticsearch.delete_by_query(index="embeddings_index_v2", body=delete_query)

# Schritt 2: Abrufen von frischem Inhalt und Erstellen neuer Chunks

fresh_content = fetch_from_drupal(doc_id, doc_type)

new_chunks = chunk_content(fresh_content)

# Schritt 3: Indizieren neue Chunks

index_chunks(new_chunks)

Elasticsearch Refresh-Intervall

Wir konfigurieren Elasticsearch mit einem Refresh-Intervall von 30 Sekunden. Dies gleicht die Echtzeit-Sichtbarkeit mit der Systemleistung aus. Neue Dokumente werden innerhalb von 30 Sekunden nach dem Indizieren durchsuchbar, das ist akzeptabel für unseren Anwendungsfall und verhindert übermäßigen Refresh-Overhead.

Für Organisationen, die schnellere Updates benötigen (z.B. Breaking News), können Sie dies auf 1-5 Sekunden reduzieren, auf Kosten eines höheren CPU- und Speicherverbrauchs.

Metadaten-Zeitstempel

Jeder indizierte Chunk enthält Metadaten darüber, wann er erstellt und indiziert wurde:

chunk_metadata = {

"node_id": "12345",

"title": "Leitfaden für Zero-Trust-Architektur",

"type": "article",

"indexed_at": "2025-10-28T14:32:10Z",

"content_updated_at": "2025-10-28T14:30:00Z"

}Der nächtliche Synchronisationsjob vergleicht diese Zeitstempel mit den Änderungszeiten von Drupal, um Abweichungen zu erkennen und nur dann eine Neuindizierung auszulösen, wenn es notwendig ist.

Wie wird die Echtzeit-Datensynchronisation in der Praxis umgesetzt?

Lassen Sie uns die tatsächlichen Implementierungsmuster untersuchen, die wir in der Produktion verwenden. Obwohl diese Beispiele zur Klarheit vereinfacht sind, repräsentieren sie real funktionierenden Code.

Webhook-Auslöser in Drupal

Das Hook-System von Drupal macht das Auslösen von Webhooks unkompliziert:

<?php

/**

* Implementiert hook_ENTITY_TYPE_update() für Knoten-Entitäten.

*/

function ai_sync_node_update(NodeInterface $node) {

// Synchronisiere nur spezifische Inhaltstypen

$sync_types = ['article', 'page', 'glossary_item', 'method'];

if (!in_array($node->bundle(), $sync_types)) {

return;

}

// Nur veröffentlichte Knoten

if (!$node->isPublished()) {

return;

}

// Bestimme den Endpunkt des Entitätstyps

$entity_type_map = [

'article' => 'articles',

'page' => 'pages',

'glossary_item' => 'glossary',

'method' => 'methods',

];

$endpoint_type = $entity_type_map[$node->bundle()];

$webhook_url = "https://ai-api.example.com/embeddings/{$endpoint_type}/create";

// Sende Webhook

try {

\Drupal::httpClient()->post($webhook_url, [

'json' => ['nid' => $node->id()],

'timeout' => 5, // Blockiere nicht die Speicheroperation

]);

\Drupal::logger('ai_sync')->info(

'Gesendeter Re-Index-Webhook für @type @nid',

['@type' => $node->bundle(), '@nid' => $node->id()]

);

} catch (\Exception $e) {

// Protokolliere Fehler, aber verhindere nicht das Speichern

\Drupal::logger('ai_sync')->error(

'Webhook gescheitert für @nid: @message',

['@nid' => $node->id(), '@message' => $e->getMessage()]

);

}

}

Wichtige Umsetzungsdetails:

- Nicht blockierend: verwendet kurze Timeout-Zeit, um zu verhindern, dass eine langsame API das Speichern von Inhalten blockiert.

- Fehlerbehandlung: protokolliert Fehler, verhindert aber nicht den Speichervorgang in Drupal.

- Selektive Synchronisation: löst nur für relevante Inhaltstypen aus.

- Nur veröffentlicht: Entwürfe lösen keine Webhooks aus (konfigurierbar je nach Bedarf).

Python-API-Endpunkt

Unsere Flask-Anwendung stellt entitätsspezifische Endpunkte zur Verfügung:

from flask import Flask, request, jsonify

from services.elasticsearch_service import ElasticsearchService

from services.drupal_jsonapi import fetch_entity

from services.chunker import chunk_entity

app = Flask(__name__)

es_service = ElasticsearchService()

@app.route('/embeddings/<entity_type>/create', methods=['POST'])

def reindex_entity(entity_type):

"""

Echtzeit-Re-Indexing-Endpunkt ausgelöst durch Drupal Webhooks.

Args:

entity_type: Art der Entität (Artikel, Autoren, Glossar, etc.)

Anforderungskörper:

{"nid": "12345"} oder {"tid": "67890"}

"""

try:

# Anforderung analysieren

data = request.get_json()

entity_id = data.get('nid') or data.get('tid')

if not entity_id:

return jsonify({'error': 'Fehlende Entitäts-ID'}), 400

# Entitätstyp überprüfen

valid_types = [

'articles', 'authors', 'books', 'events', 'glossary',

'methods', 'pages', 'page_managers', 'services',

'software', 'terms', 'tools'

]

if entity_type not in valid_types:

return jsonify({'error': f'Ungültiger Entitätstyp: {entity_type}'}), 400

# Schritt 1: Vorhandene Chunks löschen

deleted_count = es_service.delete_chunks_by_entity(

entity_id=entity_id,

entity_type=entity_type

)

# Schritt 2: Frischen Inhalt aus Drupal JSON API abrufen

fresh_content = fetch_entity(entity_id, entity_type)

if not fresh_content:

return jsonify({'error': 'Entität nicht in Drupal gefunden'}), 404

# Schritt 3: Den Inhalt aufteilen

chunks = chunk_entity(fresh_content, entity_type)

# Schritt 4: Neue Chunks indizieren

indexed_count = es_service.index_chunks(

chunks=chunks,

index_name='embeddings_index_v2'

)

# Erfolgreiche Antwort

return jsonify({

'status': 'success',

'entity_type': entity_type,

'entity_id': entity_id,

'deleted_chunks': deleted_count,

'indexed_chunks': indexed_count,

'message': f'Erfolgreich re-indiziert {entity_type}/{entity_id}'

}), 200

except Exception as e:

# Fehler protokollieren und 500 zurückgeben

app.logger.error(f'Re-Indizierung gescheitert für {entity_type}/{entity_id}: {str(e)}')

return jsonify({

'status': 'error',

'message': str(e)

}), 500

Highlights der Umsetzung:

- Entity Validation: stellt sicher, dass nur unterstützte Typen verarbeitet werden.

- Lösche vor dem Einfügen: sorgt für saubere Aktualisierungen ohne Duplikate.

- Umfassende Fehlerbehandlung: Misserfolge werden protokolliert und als HTTP 500 zurückgegeben.

- Detaillierte Antworten: informiert den Aufrufer, was passiert ist (gelöschte/erstellte Chunks).

- Modulare Dienste: delegiert an spezialisierte Dienste für Elasticsearch, Drupal API, chunking.

Auch lesenswert: Wie Sie Ihren RAG-Stack auswählen – LangChain, LangGraph, Raw OpenAI →

Nächtlicher Synchronisationsjob

Die Konsistenzprüfung wird als geplanter CLI-Befehl ausgeführt:

import click

from flask.cli import with_appcontext

from services.drupal_jsonapi import get_all_entity_ids

from services.elasticsearch_service import get_indexed_entity_ids

from datetime import datetime, timedelta

@click.command('sync_all_articles')

@with_appcontext

def sync_all_articles():

"""

Nächtliche Konsistenzprüfung: Stellt sicher, dass alle Drupal-Artikel indiziert sind.

"""

click.echo(f'[{datetime.now()}] Beginne Artikel-Synchronisation...')

// Alle Artikel-IDs aus Drupal heraussuchen

drupal_article_ids = set(get_all_entity_ids('articles'))

click.echo(f'Gefunden {len(drupal_article_ids)} Artikel in Drupal')

// Alle indizierten Artikel-IDs aus Elasticsearch heraussuchen

indexed_article_ids = set(get_indexed_entity_ids('articles'))

click.echo(f'Gefunden {len(indexed_article_ids)} Artikel in Elasticsearch')

// Fehlende Artikel finden (in Drupal, aber nicht indiziert)

missing = drupal_article_ids - indexed_article_ids

// Verwaiste Chunks finden (indiziert, aber nicht mehr in Drupal)

orphaned = indexed_article_ids - drupal_article_ids

click.echo(f'Fehlt im Index: {len(missing)} Artikel')

click.echo(f'Verwaist im Index: {len(orphaned)} Artikel')

// Fehlende Artikel neu indizieren

for article_id in missing:

try:

click.echo(f'Re-Indiziere fehlenden Artikel: {article_id}')

reindex_entity_by_id(article_id, 'articles')

except Exception as e:

click.echo(f'FEHLER beim Indizieren {article_id}: {str(e)}', err=True)

// Verwaiste Chunks entfernen

for article_id in orphaned:

try:

click.echo(f'Entferne verwaiste Chunks: {article_id}')

es_service.delete_chunks_by_entity(article_id, 'articles')

except Exception as e:

click.echo(f'FEHLER beim Entfernen {article_id}: {str(e)}', err=True)

// Nach veralteten Inhalten suchen (Drupal-Änderungszeitpunkt > indizierter Zeitpunkt)

stale_count = check_and_reindex_stale_articles()

click.echo(f'Synchronisation abgeschlossen. Veraltet neu indiziert: {stale_count}')

click.echo(f'[{datetime.now()}] Artikel-Synchronisation abgeschlossen.')

def check_and_reindex_stale_articles():

"""

Sucht nach Artikeln, die in Drupal nach dem Indizierungszeitpunkt geändert wurden.

"""

stale_count = 0

// Alle indizierten Artikel mit Zeitstempeln

indexed_articles = es_service.get_all_indexed_with_timestamps('articles')

for article_id, indexed_at in indexed_articles:

// Abrufen der Drupal-Änderungszeit

drupal_updated_at = get_drupal_entity_updated_time(article_id, 'articles')

// Zeitstempel vergleichen

if drupal_updated_at > indexed_at:

click.echo(f'Veralterung festgestellt: {article_id} (Drupal: {drupal_updated_at}, Index: {indexed_at})')

reindex_entity_by_id(article_id, 'articles')

stale_count += 1

return stale_count

Merkmalen des Synchronisationsjobs:

- Vergleichen auf der Grundlage von Mengen: identifiziert effizient fehlende und verwaiste Inhalte.

- Zeitstempelüberprüfung: erfasst Inhalte, die nach der Indizierung geändert wurden.

- Detaillierte Protokollierung: berichtet, was es gefunden hat und was es behoben hat.

- Fehlertoleranz: ein Misserfolg stoppt nicht die gesamte Synchronisation.

- CLI-Integration: wird über Flask CLI oder cron ausgeführt.

Cron-Konfiguration:

# Führe nächtliche Synchronisation für alle Inhaltstypen um 2 Uhr morgens aus

0 2 * * * cd /path/to/app && flask sync_all_articles

0 2 * * * cd /path/to/app && flask sync_all_authors

0 2 * * * cd /path/to/app && flask sync_all_glossary

# ... (wiederhole für jeden Entitätstyp)Welche Ergebnisse kann die Echtzeit-Datensynchronisation in der Produktion liefern?

Unser System zur Echtzeit-Datensynchronisation läuft seit über 6 Monaten in der Produktion mit ausgezeichneter Zuverlässigkeit und Nutzerzufriedenheit.

Leistungsmerkmale

Um zu veranschaulichen, wie diese Architektur unter realen Bedingungen funktioniert, hier sind die wichtigsten Kennzahlen, die wir in der Produktion beobachtet haben.

Aktualisierungsverzögerung

- Inhalt in Drupal gespeichert → Webhook empfangen: <1 Sekunde.

- Webhook empfangen → Re-Indexierung abgeschlossen: 3-8 Sekunden (abhängig von der Dokumentengröße).

- Re-Indexierung abgeschlossen → durchsuchbar im Chatbot: <30 Sekunden (Elasticsearch-Aktualisierung).

- Insgesamt: Inhalt steht den Nutzern innerhalb von 30 Sekunden nach Veröffentlichung zur Verfügung.

Synchronisationsabdeckung

- 11 Entitätstypen erfolgreich synchronisiert.

- 10.000-15.000 gesamt Chunks über alle Typen hinweg.

- 99,8% Webhook-Erfolgsrate (überwacht über 3 Monate)

- 0,2% verpasste Webhooks wurden durch nächtliche Synchronisation erfasst.

Systemverlässlichkeit

- Null Duplikate dank Lösche-vor-Einfüge-Muster.

- Nächtliche Synchronisation erfasst 2-5 verpasste Aktualisierungen pro Nacht (von Webhook-Ausfällen).

- Null Verwaiste Chunks nach Implementierung der Bereinigungslogik.

- Konsistenter Zustand zwischen Drupal und Elasticsearch, täglich überprüft.

Auch lesenswert: Wie beschleunigen Sie AI-Chatbot-Antworten mit intelligentem Caching →

Betriebliche Vorteile

Abgesehen von der reinen Leistung bietet die Echtzeit-Datensynchronisation auch verschiedene praktische betriebliche Vorteile, die Arbeitsabläufe vereinfachen und den langfristigen Wartungsaufwand reduzieren.

Unabhängigkeit des Content-Teams

Schreiber und Redakteure veröffentlichen Inhalte, ohne sich um die Indexierung kümmern zu müssen. Das System handhabt die Synchronisation automatisch und entfernt eine Schicht technischer Komplexität aus ihrem Workflow.

Reduzierter Wartungsaufwand

Keine manuelle Ne

Wann Echtzeitsynchronisation Sinn macht (und wann nicht)

Echtzeit-Datensynchronisation erhöht die Infrastrukturkomplexität und den Betriebsaufwand. Zu verstehen, wann dies gerechtfertigt ist, stellt sicher, dass Sie Ressourcen sinnvoll einsetzen.

Ideale Anwendungsfälle für Echtzeitsynchronisation

Hier sind einige Beispiele für Situationen, in denen die Echtzeitsynchronisation von Daten sinnvoll ist.

Häufig aktualisierter Inhalt

Wenn Ihre Wissensbasis tägliche oder stündliche Updates erhält, ist die Echtzeitsynchronisation essentiell. Nachrichtenseiten, Produktdokumentationen, Richtliniendatenbanken und Veranstaltungskalender profitieren alle von einer sofortigen Synchronisation.

Nutzerorientierte Wissensdatenbanken

Wenn externe Benutzer oder Kunden auf Ihren Chatbot zugreifen, erwarten sie aktuelle Informationen, die mit Ihrer Website übereinstimmen. Veraltete Informationen in nutzerorientierten Systemen schaden dem Markenimage und dem Vertrauen.

CMS-Plattformen mit mehreren Autoren

Organisationen mit Dutzenden von Inhaltserstellern, die unabhängig voneinander veröffentlichen, benötigen eine automatisierte Synchronisation. Manuelle Koordination skaliert schlecht über eine Handvoll Redakteure hinaus.

Wettbewerbsunterscheidung

Wenn Wettbewerber veraltete Chatbots anbieten, wird die Bereitstellung von Echtzeit-Antworten zu Ihrem Wettbewerbsvorteil, der die Akzeptanz und Loyalität fördert.

Dynamische Produktdokumentation

SaaS-Unternehmen, die wöchentlich Funktionen veröffentlichen, benötigen sofort durchsuchbare Dokumentationen. Das Warten auf 24 Stunden für das Batch-Indexieren frustriert Nutzer, die neue Funktionen erlernen.

Wann Echtzeitsynchronisation übertrieben sein könnte

Zum Vergleich sollten Sie Umstände in Betracht ziehen, in denen die Echtzeit-Datensynchronisation unnötig ist.

Selten aktualisierter Inhalt

Wenn sich Ihre Wissensbasis vierteljährlich oder seltener ändert, reicht das Batch-Indexieren aus. Die Komplexität von Webhooks und Echtzeitsynchronisation ist für statischen Inhalt nicht gerechtfertigt.

Interne Wissensdatenbanken mit Toleranz für Verzögerungen

Wenn Benutzer verstehen und akzeptieren, dass die interne Dokumentation um einen Tag verzögert sein könnte, funktioniert eine einfachere planmäßige Indexierung gut. Echtzeit wird eher "schön zu haben" als essentiell.

Kleine Inhaltsmengen

Bei weniger als 100 Dokumenten wird selbst die vollständige Neuindizierung jede Stunde schnell abgeschlossen. Die zusätzliche Komplexität einer Webhook-Infrastruktur ist möglicherweise nicht lohnenswert.

Sehr knappes Budget

Echtzeitsynchronisation erfordert zusätzliche Infrastruktur: Webhook-Endpunkthosting, erhöhter API-Verkehr zum CMS, häufigere Elasticsearch-Operationen. Wenn das Budget extrem eingeschränkt ist, reduziert das tägliche Batch-Indexieren die Kosten.

Einzelautor-Blogs

Einzelne Blogger oder kleine Teams, die einige Beiträge pro Monat veröffentlichen, können die Neuindizierung manuell auslösen, wenn dies erforderlich ist. Der Komfort der Automatisierung rechtfertigt den Aufwand für die Einrichtung nicht.

Wichtige Überlegungen für die Entscheidung

Bevor Sie sich entscheiden, in Echtzeitsynchronisation zu investieren, ist es wichtig, mehrere praktische Faktoren zu bewerten, die den Gesamtwert und die Komplexität der Lösung beeinflussen.

Bewerten Sie die Häufigkeit der Inhaltsaktualisierung:

- Tägliche/stündliche Updates → Echtzeitsynchronisation istunverzichtbar.

- Wöchentliche Updates → Echtzeit ist schön zu haben.

- Monatliche Updates → Batch-Indexierung ist ausreichend.

Bewerten Sie die Benutzererwartungen:

- Externe Benutzer → erwarten Echtzeitinformationen.

- Internes Team → kann eine angemessene Verzögerung tolerieren.

- Technische Benutzer → könnten akzeptieren "re-index manually" Tasten.

Berücksichtigen Sie die Komplexität der Infrastruktur:

- Haben Sie DevOps-Ressourcen für die Webhook-Wartung?

- Fühlen Sie sich beim Debugging von asynchronen Systemen wohl?

- Ist eine Überwachungs- und Warninfrastruktur vorhanden?

Berechnen Sie Kosten-Nutzen:

- Was sind die Geschäftskosten für veraltete Informationen?

- Wie viele Support-Tickets entstehen durch veraltete Antworten?

- Rechtfertigt die Echtzeitsynchronisation die zusätzlichen Infrastrukturkosten?

Echtzeit-Datensynchronisation für RAG – Schlussfolgerung

Die Echtzeitsynchronisation von RAG verwandelt Ihren KI-Chatbot von einer statischen Momentaufnahme in ein lebendiges Wissenssystem, das stets aktuell mit Ihrem Inhalt bleibt. Durch die Implementierung von Webhook-basierten Updates mit nächtlichen Konsistenzprüfungen haben wir eine Update-Latenz von unter 30 Sekunden bei 11 Inhaltstypen erreicht und dabei eine Zuverlässigkeit von 99,8 % gewahrt.

Die zentrale Erkenntnis besteht darin, dass die Aktualität der Inhalte das Benutzervertrauen und die Systemakzeptanz direkt beeinflusst. Wenn Benutzer feststellen, dass Ihr Chatbot veraltete Antworten gibt, hören sie auf, ihn zu benutzen – unabhängig davon, wie genau oder hilfreich er sonst sein mag. Die Echtzeitsynchronisation stellt sicher, dass jede veröffentlichte Aktualisierung sofort bei den Benutzern ankommt und Vertrauen in das System aufbaut.

Unsere duale Architektur – Webhooks für Echtzeit-Updates, nächtliche Synchronisation für Konsistenz – bietet das Beste aus beiden Welten: Reaktionsfähigkeit, wenn Webhooks perfekt funktionieren, Zuverlässigkeit, wenn sie ausfallen. Diese Redundanz bedeutet Null manuellen Eingriff erforderlich in 6+ Monaten des Produktionsbetriebs.

Für unseren Einsatz, der 10.000+ Inhaltsblöcke auf 11 Inhaltstypen handhabt, war die Investition in die Infrastruktur absolut gerechtfertigt. Inhalts-Teams veröffentlichen zuversichtlich, wohl wissend, dass ihre Arbeit sofort sichtbar ist. Benutzer vertrauen darauf, dass der Chatbot aktuelle Informationen liefert. Die Betriebsteams müssen nur selten eingreifen. Das System funktioniert einfach.

Wenn Ihre Wissensbasis häufig aktualisiert wird und Benutzer aktuelle Informationen erwarten, sollte die Echtzeit-Datensynchronisation eine grundlegende Anforderung sein, nicht nur eine optionale Verbesserung. Beginnen Sie mit Webhooks für Ihren am häufigsten aktualisierten Inhaltstyp, beweisen Sie, dass das Muster funktioniert, und skalieren Sie dann auf zusätzliche Typen. Die Komplexität ist real, aber handhabbar, und die Transformation des Benutzererlebnisses macht sie lohnenswert.

Möchten Sie Echtzeit-RAG-Systeme aufbauen?

Dieser Blogbeitrag basiert auf unserer echten Produktionsimplementierung eines Systems, das Echtzeit-Inhaltssynchronisation durch Webhooks liefert und Tausende von Benutzern auf 11 dynamisch aktualisierten Inhaltstypen unterstützt. Für die vollständige Aufschlüsselung dieses Projekts, erkunden Sie unsere AI-Dokument-Chatbot-Fallstudie.

Sind Sie daran interessiert, ein RAG-System auf Produktionsniveau mit Echtzeitsynchronisation und starken Konsistenzgarantien aufzubauen oder zu optimieren? Unser Team ist spezialisiert auf die Gestaltung generativer KI-Anwendungen, die auch in sich schnell verändernden Inhaltsumgebungen genau, aktualisiert und skalierbar bleiben. Besuchen Sie unsere Seite für generativen KI-Entwicklungsdienste, um zu erfahren, wie wir Ihnen dabei helfen können, die beste Architektur für Ihr Projekt zu wählen und zu implementieren.