Synchronisation des données en temps réel pour RAG. Comment maintenir la fraîcheur des connaissances de votre chatbot IA

Votre équipe marketing vient de publier une mise à jour importante de la politique. Deux heures plus tard, un utilisateur demande à votre chatbot IA à propos de la nouvelle politique, et il explique avec confiance l'ancienne version, sans savoir que quoi que ce soit a changé. L'utilisateur, confus par la différence avec ce qu'il a lu sur le site Web, ouvre un ticket de support demandant pourquoi le chatbot est "cassé". Votre équipe explique que le chatbot a besoin d'une réindexation manuelle, qui se fait chaque nuit. La confiance de l'utilisateur dans votre système d'IA chute significativement.

C'est la fragilité cachée des mises en œuvre RAG statiques : la base de connaissances devient obsolète dès que le contenu change. Dans les organisations en mouvement rapide où la documentation, les politiques et les informations sur les produits sont mises à jour quotidiennement ou même chaque heure, un chatbot avec les connaissances d'hier est pire qu'aucun chatbot du tout. Les utilisateurs attendent des informations à jour, et quand l'IA ne parvient pas à fournir, ils cessent de l'utiliser.

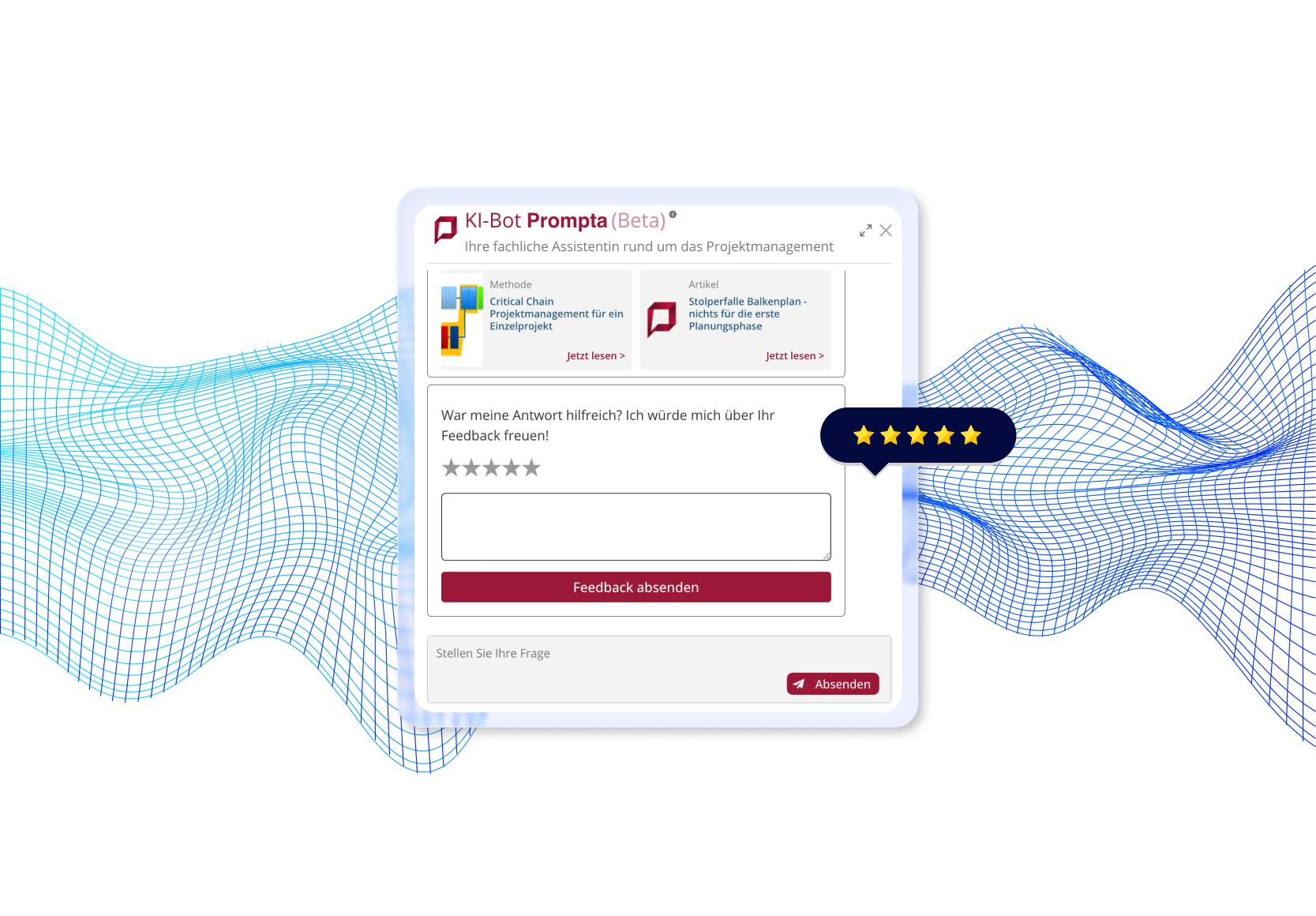

Nous avons rencontré ce défi exact lors de la construction d'un chatbot de document AI pour une plateforme de gestion des connaissances professionnelles publiant des dizaines d'articles et de mises à jour hebdomadaires. En mettant en œuvre un système de synchronisation en temps réel à l'aide de webhooks et de vérifications de cohérence nocturnes, nous avons réalisé des mises à jour visibles pour les utilisateurs en moins de 30 secondes tout en conservant la fiabilité du système sur 11 types de contenu différents.

Dans cet article, je vais vous guider à travers le problème des connaissances périmées, expliquer notre architecture de synchronisation à deux niveaux, partager les détails de mise en œuvre avec des exemples de code de production, et vous aider à décider quand le RAG en temps réel a du sens pour votre application.

Dans cet article:

- Qu'est-ce que le problème des connaissances périmées dans le RAG statique?

- La synchronisation des données en temps réel à la rescousse

- Comment fonctionne une architecture de synchronisation en temps réel?

- Comment la synchronisation des données en temps réel est-elle mise en œuvre dans la pratique?

- Quels résultats la synchronisation en temps réel peut-elle produire en production?

- Quand la synchronisation en temps réel a-t-elle du sens (et quand ce n'est pas le cas)?

- Synchronisation de données en temps réel pour RAG - conclusion

- Vous voulez construire des systèmes RAG en temps réel?

Qu'est-ce que le problème des connaissances périmées dans RAG statique?

La plupart des systèmes RAG considèrent l'indexation comme une opération par lots une fois ou programmée. Vous scrappez ou chargez vos documents, les divisez en morceaux, générez des embeddings, les stockez dans une base de données vectorielle, et considérez le travail terminé. Cela fonctionne parfaitement, jusqu'à ce que votre contenu change.

Approches traditionnelles d'indexation

Les approches traditionnelles d'indexation reposent sur des mises à jour périodiques ou manuelles qui introduisent inévitablement des retards entre le changement de contenu et ce que le chatbot peut récupérer.

Indexation par lots

Les organisations réindexent généralement toute leur base de connaissances selon un calendrier : hebdomadaire, journalier, ou (optimistement) horaire. Un script s'exécute, traite tous les documents, régénère les embeddings, et met à jour la base de données vectorielle. Simple, prévisible, et de plus en plus inadéquat.

Déclencheurs manuels

Certaines équipes mettent en œuvre des boutons "re-indexer maintenant" que les gestionnaires de contenu cliquent après avoir publié les changements. Cela nécessite de la discipline, ajoute du frottement aux flux de travail de contenu, et est inévitablement oublié pendant les périodes chargées ou les mises à jour urgentes.

Réindexation complète programmée

L'approche la plus commune : les tâches cron nocturnes qui retraitent toute la base de connaissances. Cela assure une cohérence éventuelle mais crée une fenêtre de quelques heures ou jours où le chatbot fonctionne sur des informations périmées.

La synchronisation de données en temps réel à la rescousse

La synchronisation de données en temps réel élimine ces fenêtres d'obsolescence en mettant à jour automatiquement la base de connaissances dans les secondes qui suivent les changements de contenu. Au lieu d'attendre des tâches programmées ou nécessitant des déclencheurs manuels, le système reçoit des notifications par webhook à l'instant où les éditeurs enregistrent les changements dans le CMS. Cette approche basée sur des événements signifie que les utilisateurs interrogent toujours l'information courante sans aucune coordination entre les équipes de contenu et les opérations techniques.

Comment fonctionne une architecture de synchronisation en temps réel?

Notre solution de production met en œuvre une approche à deux niveaux qui équilibre la réactivité immédiate avec la cohérence à long terme. L'architecture se compose de quatre composants clés travaillant ensemble pour garantir que les connaissances du chatbot restent actuelles.

Composant 1 : Réindexation basée sur les webhooks

La base de la synchronisation des données en temps réel est les mises à jour basées sur les événements. Lorsque le contenu change dans la solution CMS, le chatbot en est immédiatement informé à travers les webhooks.

Comment ça marche :

- Éditeur de contenu enregistre un document : un éditeur met à jour un article, ajoute un nouveau terme au glossaire, ou modifie une page de base de connaissances dans Drupal et clique sur "Sauvegarder".

- Drupal déclenche le webhook : immédiatement après avoir sauvegardé, Drupal envoie une requête POST à notre API Python avec le type d'entité et l'ID:

POST https://ai-api.exemple.com/embeddings/articles/create

Corps : {"nid": "12345"} - API Python reçoit la notification : notre application Flask reçoit le webhook et identifie quel contenu a changé.

- Supprimer les anciens chunks : nous trouvons tous les chunks existants pour ce document dans Elasticsearch et les supprimons. Cela évite les doublons et assure des mises à jour propres.

- Obtenir un contenu frais : le système appelle l'API JSON de Drupal pour récupérer la dernière version du contenu avec tous les métadonnées, paragraphes et sections structurées.

- Re-chunker le contenu : nous appliquons notre stratégie de segmentation sémantique (200-700 jetons par chunk) pour décomposer le document mis à jour en morceaux optimaux pour la récupération.

- Réindexer vers Elasticsearch : les nouveaux chunks avec des embeddings frais sont stockés dans notre base de données vectorielle, remplaçant les anciennes versions.

- Mise à jour visible en <30 secondes : L'intervalle de rafraîchissement d'Elasticsearch (30 secondes) détermine quand le nouveau contenu devient consultable. De la sauvegarde à la disponibilité : moins de 30 secondes.

Composant 2 : Points finaux spécifiques à l'entité

Plutôt qu'un seul point final de réindexation générique, nous mettons en œuvre des points finaux dédiés pour chaque type de contenu. Cette approche modulaire offre flexibilité et isolation.

Nos points finaux :

- /embeddings/articles/create

- Articles de blog et contenu long-forme

- /embeddings/authors/create

- Profils d'auteurs et biographies

- /embeddings/books/create

- Références de livres et critiques

- et plus encore.

Avantages des points finaux spécifiques à l'entité :

- Échecs isolés : si l'indexation des auteurs échoue, les articles continuent de fonctionner.

- Traitement spécifique au type : chaque type de contenu a des exigences de segmentation uniques.

- Expansion facile : l'ajout de nouveaux types de contenu n'affecte pas ceux existants.

- Journalisation claire : les erreurs indiquent exactement quel type et quelle entité ont échoué.

- Traitement optimisé : différents types de contenu peuvent utiliser différentes stratégies.

Exemple d'un projet dans lequel nous avons mis en œuvre RAG en temps réel avec synchronisation par webhooks.

Explorez l'étude de cas complète : Chatbot de document IA →

Composant 3 : Travail de synchronisation nocturne

Les webhooks fournissent des mises à jour en temps réel, mais ils ne sont pas infaillibles. Les échecs de réseau, les délais d'expiration de l'API ou les problèmes de livraison de webhook peuvent entraîner des mises à jour manquées. Notre travail de synchronisation nocturne joue le rôle de filet de sécurité.

Ce qu'il fait tous les soirs à 2h du matin :

- Extraction de tous les ID de contenu de Drupal : interrogez Drupal pour obtenir des listes complètes de tous les articles, auteurs, termes, etc.

- Comparer avec le contenu indexé : vérifiez Elasticsearch pour voir ce qui est actuellement indexé, y compris les horloges de métadonnées.

- Détection des écarts : identifiez le contenu qui existe dans Drupal mais pas dans l'index, ou le contenu dont les horloges indiquent qu'il a changé depuis l'indexation.

- Réindexation sélective : réindexez uniquement le contenu manquant ou périmé, et non toute la base de connaissances.

- Rapport de cohérence : journalisez les statistiques : combien d'articles étaient en désynchronisation, combien ont été réindexés, taux de succès/échec.

Commandes CLI pour les opérations manuelles :

# Réindexer tous les articles

flask index_articles

# Réindexer tous les auteurs

flask index_authors

# Réindexer une entité spécifique

flask reindex_article --nid 12345

# Vérification de la cohérence complète sur tous les types

flask verify_sync_allCette interface de ligne de commande permet à l'équipe d'exploitation de déclencher manuellement la réindexation si nécessaire, utile pour le dépannage ou les mises à jour d'urgence.

Composant 4 : Mécanismes de cohérence

Plusieurs modèles techniques assurent l'intégrité des données tout au long du processus de synchronisation.

Modèle de suppression avant insertion

Lors de la réindexation d'un document, nous supprimons toujours les chunks existants avant de créer de nouveaux. Cela évite les doublons si le même contenu est indexé plusieurs fois et garantit des transitions d'état propres.

def reindex_document(doc_id, doc_type):

# Étape 1 : Supprimez tous les chunks existants

delete_query = {

"query": {

"bool": {

"must": [

{"term": {"metadata.node_id": doc_id}},

{"term": {"metadata.type": doc_type}}

]

}

}

}

elasticsearch.delete_by_query(index="embeddings_index_v2", body=delete_query)

# Étape 2 : Récupérez un contenu frais et créez de nouveaux chunks

fresh_content = fetch_from_drupal(doc_id, doc_type)

new_chunks = chunk_content(fresh_content)

# Étape 3 : Indexez de nouveaux chunks

index_chunks(new_chunks)Intervalle de rafraîchissement d'Elasticsearch

Nous configurons Elasticsearch avec un intervalle de rafraîchissement de 30 secondes. Cela équilibre la visibilité en temps réel avec les performances du système. Les nouveaux documents sont consultables dans les 30 secondes qui suivent leur indexation, ce qui est acceptable pour notre cas d'utilisation tout en évitant un surcroît de rafraîchissement.

Pour les organisations nécessitant des mises à jour plus rapides (par exemple, les actualités de dernière heure), vous pouvez réduire cela à 1-5 secondes au coût d'une utilisation plus élevée de la CPU et de la mémoire.

Horloges de métadonnées

Chaque chunk indexé inclut des métadonnées sur le moment où il a été créé et indexé :

chunk_metadata = {

"node_id": "12345",

"title": "Guide de l'Architecture Zero-Trust",

"type": "article",

"indexed_at": "2025-10-28T14:32:10Z",

"content_updated_at": "2025-10-28T14:30:00Z"

}Le travail de synchronisation nocturne compare ces horloges avec les temps de modification de Drupal pour détecter les dérives et déclencher la réindexation uniquement lorsque nécessaire.

Comment est mise en œuvre la synchronisation de données en temps réel en pratique ?

Examinons les schémas de mise en œuvre que nous utilisons en production. Bien que ces exemples soient simplifiés pour plus de clarté, ils représentent un code fonctionnel réel.

Déclencheur de Webhook dans Drupal

Le système de crochet de Drupal rend le déclenchement du webhook simple :

<?php

/**

* Implémente hook_ENTITY_TYPE_update() pour les entités de nœud.

*/

function ai_sync_node_update(NodeInterface $node) {

// Synchroniser uniquement certains types de contenu

$sync_types = ['article', 'page', 'glossary_item', 'method'];

if (!in_array($node->bundle(), $sync_types)) {

return;

}

// Seulement les nœuds publiés

if (!$node->isPublished()) {

return;

}

// Déterminer le point de terminaison du type d'entité

$entity_type_map = [

'article' => 'articles',

'page' => 'pages',

'glossary_item' => 'glossary',

'method' => 'methods',

];

$endpoint_type = $entity_type_map[$node->bundle()];

$webhook_url = "https://ai-api.example.com/embeddings/{$endpoint_type}/create";

// Envoyer le webhook

try {

\Drupal::httpClient()->post($webhook_url, [

'json' => ['nid' => $node->id()],

'timeout' => 5, // Ne pas bloquer l'opération de sauvegarde

]);

\Drupal::logger('ai_sync')->info(

'Webhook de réindexation envoyé pour @type @nid',

['@type' => $node->bundle(), '@nid' => $node->id()]

);

} catch (\Exception $e) {

// Journaliser l'erreur mais ne pas empêcher la sauvegarde

\Drupal::logger('ai_sync')->error(

'Échec du webhook pour @nid: @message',

['@nid' => $node->id(), '@message' => $e->getMessage()]

);

}

}

Détails clés de la mise en œuvre :

- Non bloquant : utilise un délai d'attente court pour empêcher qu'une API lente bloque les sauvegardes de contenu.

- Gestion des erreurs : enregistre les échecs mais n'empêche pas l'opération de sauvegarde de Drupal.

- Synchronisation sélective : ne se déclenche que pour les types de contenu pertinents.

- Publié uniquement : les brouillons ne déclenchent pas les webhooks (configurable en fonction des besoins).

Point terminaison de l'API Python

Notre application Flask expose des points de terminaison spécifiques aux entités :

from flask import Flask, request, jsonify

from services.elasticsearch_service import ElasticsearchService

from services.drupal_jsonapi import fetch_entity

from services.chunker import chunk_entity

app = Flask(__name__)

es_service = ElasticsearchService()

@app.route('/embeddings/<entity_type>/create', methods=['POST'])

def reindex_entity(entity_type):

"""

Point terminaison de ré-indexation en temps réel déclenché par les webhooks de Drupal.

Args:

entity_type: Type d'entité (articles, auteurs, glossaire, etc.)

Corps de la demande :

{"nid": "12345"} ou {"tid": "67890"}

"""

try:

# Analyse la demande

data = request.get_json()

entity_id = data.get('nid') or data.get('tid')

if not entity_id:

return jsonify({'error': 'ID entité manquante'}), 400

# Valide le type d'entité

valid_types = [

'articles', 'authors', 'books', 'events', 'glossary',

'methods', 'pages', 'page_managers', 'services',

'software', 'terms', 'tools'

]

if entity_type not in valid_types:

return jsonify({'error': f'Type d\'entité invalide : {entity_type}'}), 400

# Étape 1 : Supprimer les morceaux existants

deleted_count = es_service.delete_chunks_by_entity(

entity_id=entity_id,

entity_type=entity_type

)

# Étape 2 : Récupère le contenu frais de l'API JSON de Drupal

fresh_content = fetch_entity(entity_id, entity_type)

if not fresh_content:

return jsonify({'error': 'Entité non trouvée dans Drupal'}), 404

# Étape 3 : Morceler le contenu

chunks = chunk_entity(fresh_content, entity_type)

# Étape 4 : Indexer les nouveaux morceaux

indexed_count = es_service.index_chunks(

chunks=chunks,

index_name='embeddings_index_v2'

)

# Réponse de succès

return jsonify({

'status': 'success',

'entity_type': entity_type,

'entity_id': entity_id,

'deleted_chunks': deleted_count,

'indexed_chunks': indexed_count,

'message': f'Succès de la ré-indexation {entity_type}/{entity_id}'

}), 200

except Exception as e:

# Journaliser l'erreur et retourner 500

app.logger.error(f'Échec de la ré-indexation pour {entity_type}/{entity_id} : {str(e)}')

return jsonify({

'status': 'error',

'message': str(e)

}), 500

Moments forts de la mise en œuvre :

- Validation de l'entité : s'assure que seuls les types pris en charge sont traités.

- Suppression avant insertion : mises à jour propres sans doublons.

- Gestion complète des erreurs :les échecs sont enregistrés et renvoyés comme HTTP 500.

- Réponses détaillées :informe l'appelant de ce qui s'est passé (morceaux supprimés/créés).

- Services modulaires :délègue à des services spécialisés pour Elasticsearch, API Drupal, morcellement.

Lire aussi : Comment choisir votre pile RAG - LangChain, LangGraph, Raw OpenAI →

Tâche de synchronisation nocturne

Le contrôle de cohérence s'exécute sous forme de commande CLI planifiée :

import click

from flask.cli import with_appcontext

from services.drupal_jsonapi import get_all_entity_ids

from services.elasticsearch_service import get_indexed_entity_ids

from datetime import datetime, timedelta

@click.command('sync_all_articles')

@with_appcontext

def sync_all_articles():

"""

Vérification de la cohérence nocturne : s'assurer que tous les articles de Drupal sont indexés.

"""

click.echo(f'[{datetime.now()}] Démarrage de la synchronisation des articles...')

# Récupérer tous les identifiants d'articles de Drupal

drupal_article_ids = set(get_all_entity_ids('articles'))

click.echo(f'Trouvé {len(drupal_article_ids)} articles dans Drupal')

# Récupérer tous les identifiants d'articles indexés de Elasticsearch

indexed_article_ids = set(get_indexed_entity_ids('articles'))

click.echo(f'Trouvé {len(indexed_article_ids)} articles dans Elasticsearch')

# Trouver les articles manquants (présents dans Drupal mais non indexés)

missing = drupal_article_ids - indexed_article_ids

# Trouver les morceaux orphelins (indexés mais plus dans Drupal)

orphaned = indexed_article_ids - drupal_article_ids

click.echo(f'Manquant dans l'index : {len(missing)} articles')

click.echo(f'Orphelin dans l'index : {len(orphaned)} articles')

# Réindexer les articles manquants

for article_id in missing:

try:

click.echo(f'Réindexation de l'article manquant : {article_id}')

reindex_entity_by_id(article_id, 'articles')

except Exception as e:

click.echo(f'ERREUR d'indexation {article_id}: {str(e)}', err=True)

# Supprimer les morceaux orphelins

for article_id in orphaned:

try:

click.echo(f'Suppression des morceaux orphelins : {article_id}')

es_service.delete_chunks_by_entity(article_id, 'articles')

except Exception as e:

click.echo(f'ERREUR de suppression {article_id}: {str(e)}', err=True)

# Vérifier si le contenu est périmé (modifié dans Drupal après horodatage indexé)

stale_count = check_and_reindex_stale_articles()

click.echo(f'Synchronisation terminée. Ancien réindexé : {stale_count}')

click.echo(f'[{datetime.now()}] Synchronisation des articles terminée.')

def check_and_reindex_stale_articles():

"""

Vérifie si des articles ont été modifiés dans Drupal après les horodatages indexés.

"""

stale_count = 0

# Obtenir tous les articles indexés avec horodatages

indexed_articles = es_service.get_all_indexed_with_timestamps('articles')

for article_id, indexed_at in indexed_articles:

# Récupérer l'heure de modification de Drupal

drupal_updated_at = get_drupal_entity_updated_time(article_id, 'articles')

# Comparer les horodatages

if drupal_updated_at > indexed_at:

click.echo(f'Périmé détecté: {article_id} (Drupal: {drupal_updated_at}, Index: {indexed_at})')

reindex_entity_by_id(article_id, 'articles')

stale_count += 1

return stale_count

Caractéristiques de la tâche de synchronisation :

- Comparaison basée sur des ensembles : identifie efficacement le contenu manquant et orphelin.

- Validation des horodatages : détecte le contenu modifié après l'indexation.

- Journalisation détaillée : indique ce qu'elle a trouvé et ce qu'elle a corrigé.

- Résilience aux erreurs : une défaillance n'arrête pas toute la synchronisation.

- Intégration CLI : s'exécute via CLI Flask ou cron.

Configuration du cron :

# Exécute la synchronisation nocturne pour tous les types de contenu à 2 h du matin

0 2 * * * cd /path/to/app && flask sync_all_articles

0 2 * * * cd /path/to/app && flask sync_all_authors

0 2 * * * cd /path/to/app && flask sync_all_glossary

# ... (répéter pour chaque type d'entité)Quels résultats la synchronisation de données en temps réel peut-elle apporter en production ?

Notre système de synchronisation de données en temps réel fonctionne en production depuis plus de 6 mois avec une excellente fiabilité et satisfaction des utilisateurs.

Performances metrics

Pour illustrer comment cette architecture fonctionne dans des conditions réelles, voici les principales mesures que nous avons observées en production.

Latence de la mise à jour

- Contenu enregistré dans Drupal → webhook reçu : <1 seconde.

- Webhook reçu → reindexation terminée : 3-8 secondes (dépend de la taille du document).

- Réindexation terminée → recherche dans le chatbot I.A : <30 secondes (rafraîchissement de Elasticsearch).

- Total : le contenu est disponible pour les utilisateurs dans les 30 secondes suivant sa publication.

Couverture de la synchronisation

- 11 types d'entités synchronisées avec succès.

- 10 000-15 000 fragments totaux tous types confondus.

- Taux de succès des webhooks de 99,8% (surveillé sur 3 mois)

- 0,2% de webhooks manqués attrapés par la synchronisation nocturne.

Fiabilité du système

- Zéro doublons grâce au schéma de suppression avant insertion.

- La synchronisation nocturne détecte 2-5 mises à jour manquées par nuit (à cause des échecs de webhook).

- Zéro fragments orphelins après l'implémentation de la logique de nettoyage.

- État cohérent entre Drupal et Elasticsearch vérifié quotidiennement.

Lire aussi : Comment accélérer les réponses du chatbot I.A avec un cache intelligent →

Avantages opérationnels

Au-delà des performances brutes, la synchronisation de données en temps réel offre également plusieurs avantages opérationnels pratiques qui simplifient les workflows et réduisent la maintenance à long terme.

Indépendance de l'équipe de contenu

Les rédacteurs et les éditeurs publient du contenu sans se soucier de l'indexation. Le système gère la synchronisation automatiquement, supprimant une couche de complexité technique de leur flux de travail.

Réduction de la charge de maintenance

Pas besoin de réindexation manuelle. Pas de coordination des horaires entre les équipes de contenu et de développement. Le système se maintient automatiquement grâce aux webhooks et aux vérifications de cohérence nocturnes.

Transparence des échecs

Quand les webhooks échouent (problèmes de réseau, temps d'arrêt de l'API), la synchronisation nocturne détecte et corrige automatiquement l'écart. L'équipe des opérations reçoit des rapports quotidiens mais doit rarement intervenir.

Scalabilité prouvée

Ajouter de nouveaux types de contenu prend 2 à 4 heures :

- Créer un webhook Drupal pour un nouveau type (30 minutes).

- Créer un point de terminaison Python (30 minutes).

- Mettre en place un récupérateur spécifique à une entité (1 heure).

- Mettre en place un fragmenteur spécifique à une entité (1 à 2 heures).

- Ajouter une commande de synchronisation CLI (30 minutes).

Nous avons réussi à passer d'un type de contenu (articles) à 11 types au cours du cycle de vie du projet sans aucune modification architecturale.

Quand la synchronisation en temps réel est sensée (et quand elle ne l'est pas)

La synchronisation des données en temps réel ajoute de la complexité à l'infrastructure et au coût opérationnel. Comprendre quand elle est justifiée vous permet d'investir judicieusement vos ressources.

Cas d'utilisation idéaux pour la synchronisation en temps réel

Voici quelques exemples de situations où la synchronisation des données en temps réel est sensée.

Contenu fréquemment mis à jour

Si votre base de connaissances reçoit des mises à jour quotidiennes ou horaires, la synchronisation en temps réel est essentielle. Les sites d'actualités, la documentation de produits, les bases de données de politiques et les calendriers d'événements bénéficient tous d'une synchronisation immédiate.

Bases de connaissances orientées utilisateur

Lorsque des utilisateurs externes ou des clients accèdent à votre chatbot, ils s'attendent à une information à jour qui correspond à votre site Web. Un retard dans les systèmes orientés utilisateurs endommage la réputation de la marque et la confiance.

Plateformes CMS à auteurs multiples

Les organisations avec des dizaines de créateurs de contenu qui publient indépendamment ont besoin d'une synchronisation automatisée. La coordination manuelle devient difficile à gérer au-delà d'un petit nombre d'éditeurs.

Différenciation compétitive

Si vos concurrents offrent des chatbots périmés, fournir des réponses en temps réel devient votre avantage compétitif qui favorise l'adoption et la fidélité.

Documentation de produit dynamique

Les sociétés SaaS qui sortent des fonctionnalités chaque semaine ont besoin d'une documentation instantanément recherchable. Attendre 24 heures pour l'indexation par lots frustre les utilisateurs qui apprennent de nouvelles fonctionnalités.

Quand la synchronisation en temps réel peut être exagérée

En comparaison, considérez les circonstances dans lesquelles la synchronisation des données en temps réel est inutile.

Contenu mis à jour de manière infrequente

Si votre base de connaissances change trimestriellement ou moins souvent, l'indexation par lots suffit. La complexité des webhooks et de la synchronisation en temps réel n'est pas justifiée pour le contenu statique.

Bases de connaissances internes avec tolérance pour le décalage

Lorsque les utilisateurs comprennent et acceptent que la documentation interne pourrait avoir un retard d'un jour, l'indexation programmée fonctionne très bien. Le temps réel devient "agréable à avoir" plutôt que essentiel.

Petits ensembles de contenu

Avec moins de 100 documents, même la réindexation complète toutes les heures se termine rapidement. La complexité supplémentaire de l'infrastructure webhook peut ne pas en valoir la peine.

Budgets très serrés

La synchronisation en temps réel nécessite une infrastructure supplémentaire : hébergement de points de terminaison webhook, augmentation du trafic API vers le CMS, opérations Elasticsearch plus fréquentes. Si le budget est extrêmement contraint, l'indexation quotidienne par lots réduit les coûts.

Blogs à auteur unique

Les blogueurs individuels ou les petites équipes qui publient quelques articles par mois peuvent déclencher manuellement la réindexation lorsque c'est nécessaire. L'avantage de l'automatisation ne justifie pas l'effort de configuration.

Considérations clés pour la décision

Avant de choisir d'investir dans la synchronisation en temps réel, il est important d'évaluer plusieurs facteurs pratiques qui influencent l'ensemble de la valeur et de la complexité de la solution.

Evaluer la fréquence de mise à jour du contenu:

- Mises à jour quotidiennes/horaires → synchronisation en temps réel essentielle.

- Mises à jour hebdomadaires → temps réel agréable à avoir.

- Mises à jour mensuelles → indexation par lots suffisante.

Evaluation des attentes des utilisateurs:

- Utilisateurs externes → attendent de l'information en temps réel.

- Equipe interne → peut tolérer un retard raisonnable.

- Utilisateurs techniques → pourraient accepter les boutons "réindexer manuellement".

Considérer la complexité de l'infrastructure:

- Avez-vous des ressources DevOps pour la maintenance des webhooks?

- Etes-vous à l'aise pour déboguer des systèmes asynchrones?

- Avez-vous une infrastructure de surveillance et d'alerte en place?

Calculer le coût-bénéfice:

- Quel est le coût commercial de l'information périmée?

- Combien de tickets de support résultent de réponses périmées?

- La synchronisation en temps réel justifie-t-elle le coût supplémentaire de l'infrastructure?

La synchronisation des données en temps réel pour RAG - conclusion

La synchronisation RAG en temps réel transforme votre chatbot IA d'une photo statique en un système de connaissances vivant qui reste à jour avec votre contenu. En mettant en œuvre des mises à jour basées sur des webhooks avec des vérifications de cohérence nocturnes, nous avons atteint une latence de mise à jour de moins de 30 secondes sur 11 types de contenu tout en maintenant une fiabilité de 99,8%.

La clé est de reconnaître que la fraîcheur du contenu a un impact direct sur la confiance des utilisateurs et l'adoption du système. Lorsque les utilisateurs découvrent que votre chatbot donne des réponses dépassées, ils cessent de l'utiliser, quel que soit le degré de précision ou d'utilité qu'il pourrait avoir par ailleurs. La synchronisation en temps réel garantit que chaque mise à jour publiée atteint les utilisateurs immédiatement, renforçant la confiance dans le système.

Notre architecture à deux couches - webhooks pour les mises à jour en temps réel, synchronisation nocturne pour la cohérence - offre le meilleur des deux mondes : une réactivité lorsque les webhooks fonctionnent parfaitement, une fiabilité lorsqu'ils échouent. Cette redondance signifie une intervention manuelle nulle requise pendant plus de 6 mois de fonctionnement en production.

Pour notre déploiement gérant plus de 10 000 morceaux à travers 11 types de contenu, l'investissement dans l'infrastructure était absolument justifié. Les équipes de contenu publient en toute confiance, sachant que leur travail apparaît instantanément. Les utilisateurs font confiance au chatbot pour fournir des informations actuelles. Les équipes opérationnelles n'ont que rarement besoin d'intervenir. Le système fonctionne tout simplement.

Si votre base de connaissances est fréquemment mise à jour et que les utilisateurs s'attendent à des informations actuelles, la synchronisation des données en temps réel devrait être une exigence essentielle, et non une amélioration optionnelle. Commencez par les webhooks pour le type de contenu le plus souvent mis à jour, prouvez que le modèle fonctionne, puis étendez-le à d'autres types. La complexité est réelle, mais gérable, et la transformation de l'expérience utilisateur en vaut la peine.

Vous voulez construire des systèmes RAG en temps réel ?

Ce billet de blog est basé sur notre mise en œuvre réelle en production d'un système qui fournit une synchronisation de contenu en temps réel grâce à des webhooks, au service de milliers d'utilisateurs à travers 11 types de contenu mis à jour en dynamique. Pour une explication complète de ce projet, découvrez notre étude de cas de chatbot documentaire IA.

Vous êtes intéressé par la construction ou l'optimisation d'un système RAG de niveau production avec synchronisation en temps réel et des garanties de cohérence solides ? Notre équipe se spécialise dans la conception d'applications d'IA générative qui restent précises, fraîches et évolutives, même dans des environnements de contenu en rapide évolution. Visitez notre offre d'applications d'IA générative pour savoir comment nous pouvons vous aider à choisir et à mettre en œuvre la meilleure architecture pour votre projet.